贾佳亚团队全新评测基准MR-Ben发布,拒绝大模型“高分低能”

随着人工智能领域经历GPT时刻,学术界和产业界共同发力,每月甚至每周都有新的模型问世,大模型产品之多可以说是让人眼花缭乱。为了筛选出真正业界领先的大模型产品,业内衍生出了错综复杂的各类大模型评测方式,大家都希望为大模型做出客观公正的评测,看看究竟哪家产品能力更强。

但为了在行业中“脱颖而出”,业内也不断出现类似“刷榜”的做法,通过专项针对评测题库进行“预训练”从而获取高评分,导致部分大模型出现“高分低能”的现象,在实际场景当中表现不佳。

为此,贾佳亚团队联合MIT、清华、剑桥等多家知名高校,与国内头部标注公司合作,标注了一个针对复杂问题推理过程的评测数据集MR-Ben,基于GSM8K、MMLU、LogiQA、MHPP等大模型预训练必测数据集的题目,进行“阅卷式”的范式改造,生成更难、更有区分度的新数据集,从而真实地反映模型推理能力。

从“刷题考生”变“阅卷老师”,阅卷式考察反映大模型真实水平

目前主流大模型评测是使用人类的标准化考试——选择题和填空题的方式去进行大模型评测。使用这套测试方式的好处有很多, 标准明确、指标直观,且量化结果天然具有话题性。

但作者认为这种逐步作答的思维链方式生成最终答案,并不“靠谱”。

结合大模型的训练方式来看,预训练模型在预训练时早已见过数以万亿级别的词元,很难说被评测的模型是否早已见过相应的数据,从而通过“背题”的方式回答正确。而在分步作答的时候,模型是否是基于正确的理解推理选出正确的选项,我们不得而知,因为评测的方式主要靠检查最终的答案。

尽管学术界不断地对诸如GSM8K、MMLU等数据集进行升级改造,如在GSM8K上引入多语言版本的MGSM数据集,在MMLU的基础上引入更难的题目等,依然无法摆脱选择或填空的窠臼。并且,这些数据集都已面临着严重的饱和问题,大语言模型在这些指标上的数值已经见顶,并逐渐丧失了区分度。

而贾佳亚团队的选择是从评测模式的底层进行改革,从而真实反映模型推理能力。

害怕数据泄露导致的大模型背题导致分数虚高吗?贾佳亚团队打造的MR-Ben不用重新找题出卷,也不用把题目变形来测试模型的稳健性,MR-Ben直接让模型从答题者的学生身份,转变为对答题过程的“阅卷”模式,让大模型当老师来测试它对知识点的掌握情况!

不是担心模型对解题过程毫无知觉,有可能出现“幻觉”或错误的理解,蒙对答案吗?MR-Ben直接招聘一批高水平的硕博标注者,对大量题目的解题过程进行精心标注。把解题过程是否正确,出错的位置,出错的原因都细致指出,比对大模型的阅卷结果和人类专家的阅卷结果来测试模型的知识点掌握情况。

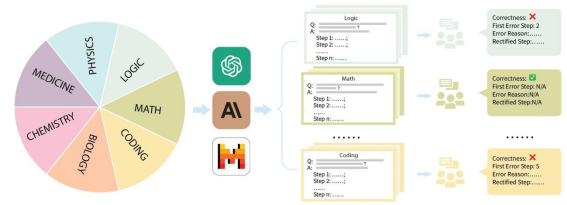

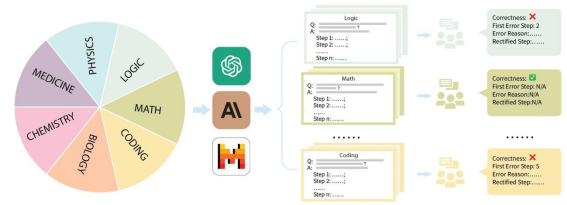

具体来说,贾佳亚团队针对市面上主流的评测数据集GSM8K、MMLU、LogiQA、MHPP等数据集进行整理,并分成了数理化生、代码、逻辑、医药等多个类别,同时区分了不同的难度等级。针对每个类别、收集到的每个问题,团队精心收集了对应的分步解题过程,并经由专业的硕博标注者进行培训和标注。

从评测方式来看,MR-Ben所提出的方法需要模型对于解题过程的每一个步骤的前提、假设、逻辑都进行细致分析,并对推理过程进行预演来判断当前步骤是否能导向正确答案。

这种“阅卷”式的评测方式从难度上远超于仅答题的评测方式,但可有效避免模型背题所导致的分数虚高问题。而只会背题的学生很难成为一名合格的阅卷老师。

其次,MR-Ben通过使用了人力精细的标注流程控制,取得了大量的高质量标注,而巧妙的流程设计又使得评测方式能够直观地量化。

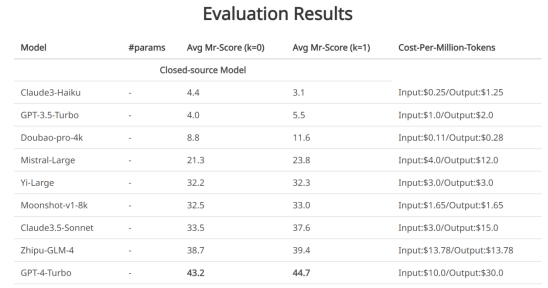

知名大模型公开评测,GPT4-Turbo表现最佳

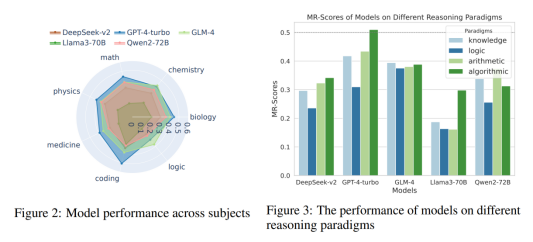

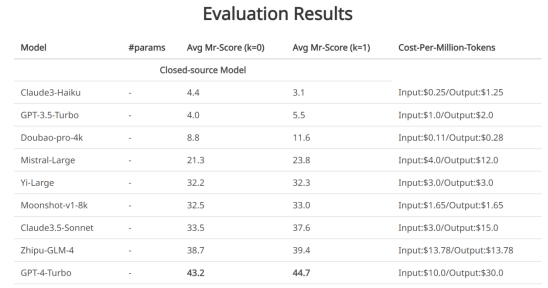

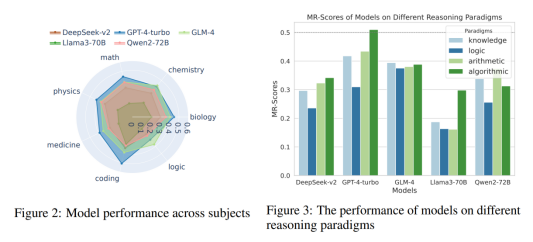

贾佳亚团队针对性测试了时下最具代表性的十大大语言模型和不同版本。可以看到,闭源大语言模型里,GPT4-Turbo的表现最佳(虽然在“阅卷”时未能发现计算错误),在绝大部分的科目里,有demo(k=1)和无demo(k=0)的设置下都领先于其他模型。

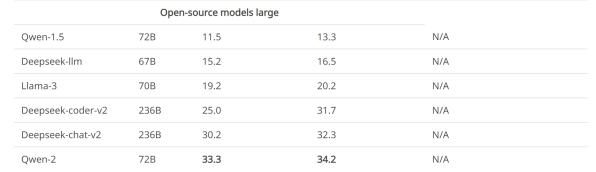

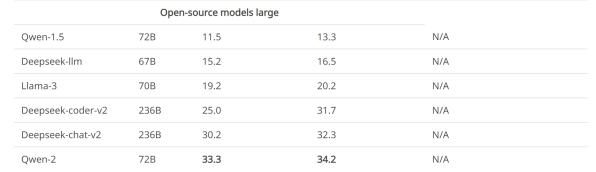

部分开源大语言模型在MR-Ben数据集上的测评结果

可以看到,最强的部分开源大语言模型效果已经赶上了部分商用模型,并且哪怕最强的闭源模型在MR-Ben数据集上表现也仍未饱和,不同模型间的区分度较大。

除此之外,MR-Ben的原论文里还有更多有意思的解析和发现,例如:

• Qwen和Deepseek发布的开源模型哪怕在全球梯队里,PK闭源模型效果也不逊色。

• 不同的闭源模型定价策略和实际表现耐人寻味。在使用场景里关注推理能力的小伙伴,可以对照价格和能力找到自己心仪的模型去使用。

• 低资源场景下,小模型也有不少亮点,MR-Ben评测中Phi-3-mini在一众小模型里脱颖而出,甚至高于或持平几百亿参数的大模型,展现出了微调数据的重要性。

• MR-Ben场景包含复杂的逻辑解析和逐步推断,Few-shot模式下过长的上下文反而会使得模型困惑,造成水平下降的后果。

• MR-Ben评测了不少生成-反思-重生成的消融实验,查看不同提示策略的差异,发现对低水平的模型没有效果,对高水平的模型如GPT4-Turbo效果也不明显。反而对中间水平的模型因为总把错的改对,对的改错,效果反而略有提升。

• 将MR-Ben评测的科目粗略划分成知识型、逻辑型、计算型、算法型后,不同的模型在不同的推理类型上各有优劣。

目前贾佳亚团队已在github上传一键评测的方式,欢迎所有关注复杂推理的小伙伴在自家的模型上评测并提交,团队会及时更新相应的leaderboard。使用官方的脚本一键评测,只需花费12M tokens左右,过程非常丝滑,值得一试。

Project Page: https://randolph-zeng.github.io/Mr-Ben.github.io/

Arxiv Page: https://arxiv.org/abs/2406.13975

Github Repo: https://github.com/dvlab-research/Mr-Ben

参考

1. Training Verifiers to Solve Math Word Problems (https://arxiv.org/abs/2110.14168)

2. Measuring Massive Multitask Language Understanding( https://arxiv.org/abs/2009.03300)

3. LogiQA: A Challenge Dataset for Machine Reading Comprehension with Logical Reasoning (https://arxiv.org/abs/2007.08124)

4. MHPP: Exploring the Capabilities and Limitations of Language Models Beyond Basic Code Generation( https://arxiv.org/abs/2405.11430)

5. Sparks of Artificial General Intelligence: Early experiments with GPT-4 (https://arxiv.org/abs/2303.12712)

6. Qwen Technical Report (https://arxiv.org/abs/2309.16609)

7. DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model (https://arxiv.org/abs/2405.04434)

8. Textbooks Are All You Need (https://arxiv.org/abs/2306.11644)

9. Large Language Models Cannot Self-Correct Reasoning Yet (https://arxiv.org/abs/2310.01798)

雷峰网(公众号:雷峰网)

雷峰网版权文章,未经授权禁止转载。